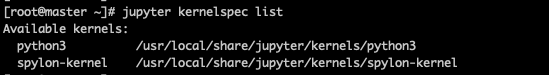

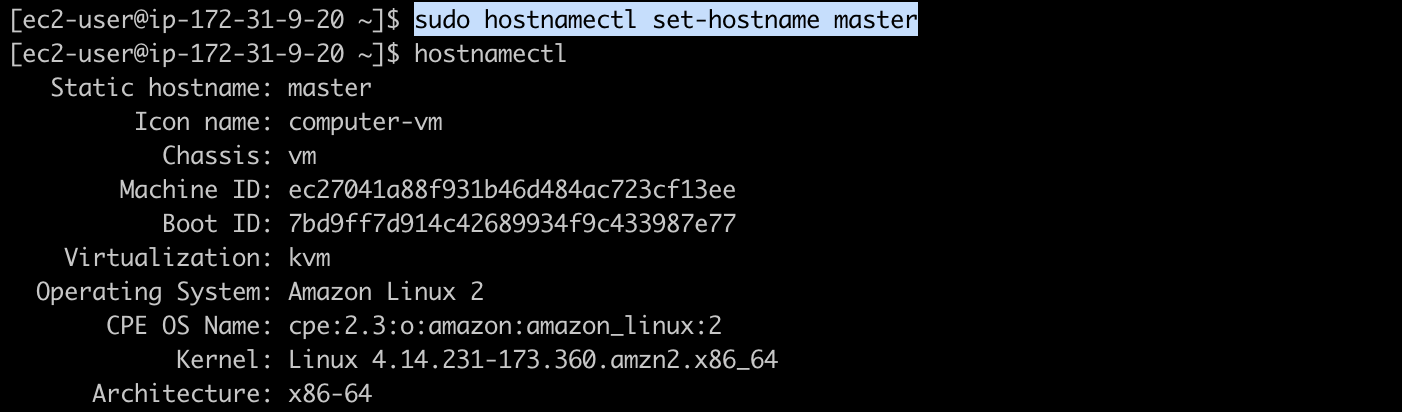

이번 포스팅에는 JypyterNotebook에 Scala커널을 추가해서, Scala를 실행해보겠습니다. 이전에 생성해놓은 인프라를 그대로 사용할 예정이니, 앞 포스팅을 차근하근히 따라오신 후 진행해주시기를 바랍니다^-^ 1. Scala 설치 저는 python3.7을 사용하므로, pip3으로 설치했습니다! 아래 명령어로 spylon_kernal을 설치하고, 커널에 추가합니다. [root@master ~]# pip3 install spylon-kernel [root@master ~]# python3 -m spylon_kernel install kernalspec 명령어로 커널 추가가 잘 되었는지 확인해봅니다. [root@master ~]# jupyter kernelspec list 2. Jupyter Not..